- Что такое GPTBot?

- Как это работает?

- Зачем это нужно?

- Основные функции GPTBot

- Вклад в экосистему AI

- Основные характеристики GPTBot

- Как GPTBot сканирует веб?

- Использование пользовательского агента

- Управление доступом к GPTBot

- Ограничение доступа

- Юридические и этические вопросы

- Вопросы авторских прав

- Заключение

- Ссылки и источники

Приветствую вас, искатели знаний в мире SEO! OpenAI недавно запустила новый веб-краулер под названием GPTBot. Этот инструмент создан для улучшения будущих моделей искусственного интеллекта. В этой статье мы рассмотрим, что это за инструмент, как он работает и какие вопросы он поднимает в области этики и законодательства.

Что такое GPTBot?

GPTBot — это новаторская система, разработанная OpenAI, которая сканирует веб в поисках ценных данных. Эти данные не просто информация, они ключевые элементы, которые могут улучшить точность, возможности и безопасность современных технологий искусственного интеллекта.

Как это работает?

GPTBot работает, просматривая интернет, ища информацию, которая может быть полезна для обучения и развития моделей ИИ. Он строго фильтрует источники с ограниченным доступом, такие как платные статьи, и отсеивает источники, которые могут нарушать политику OpenAI, такие как сбор личной информации.

Зачем это нужно?

С постоянным ростом и развитием ИИ, качество и объем данных становятся все более важными. GPTBot играет ключевую роль в этом процессе, обеспечивая высококачественные данные для обучения и улучшения моделей.

Основные функции GPTBot

GPTBot не просто инструмент; это мощный союзник в мире AI. Он может значительно улучшить модели AI, делая их более точными и надежными.

Вклад в экосистему AI

Путем разрешения доступа GPTBot к вашему сайту, вы не просто помогаете одной компании или продукту, вы вносите свой вклад во всю экосистему AI. Это сотрудничество может привести к новым открытиям и инновациям, улучшая технологию для всех.

Этот подход делает GPTBot уникальным и важным инструментом в текущей сфере искусственного интеллекта, подчеркивая его роль в обогащении и улучшении технологий, которые формируют наше будущее.

Основные характеристики GPTBot

GPTBot — это не просто веб-краулер, это интеллектуальная система, работающая по строго определенным правилам и стандартам, установленным OpenAI.

- Соблюдение правил доступа. Одной из ключевых особенностей GPTBot является его способность не заходить на сайты с платным доступом. Это означает, что он уважает ограничения доступа, установленные владельцами сайтов, и не пытается обойти платные стены или другие барьеры, которые ограничивают доступ к контенту.

- Соответствие политике OpenAI. GPTBot также строго соблюдает политику OpenAI. Это включает в себя не только отказ от доступа к определенным типам контента, но и обеспечение того, что все собранные данные используются этично и в соответствии с законами и регуляциями.

- Фильтрация источников. Система тщательно фильтрует источники, чтобы убедиться, что она не собирает информацию, которая может нарушать личную жизнь или другие чувствительные аспекты. Это включает в себя отсеивание сайтов, которые могут собирать личную информацию или нарушать другие стандарты конфиденциальности.

- Вклад в развитие ИИ. GPTBot не просто собирает данные; он делает это с целью улучшения и развития искусственного интеллекта. Это делает его важным инструментом в текущем технологическом ландшафте, подчеркивая его роль в продвижении науки и технологии вперед.

Основные характеристики GPTBot делают его уникальным и ценным инструментом в мире искусственного интеллекта. Его способность работать в рамках строгих правил и стандартов подчеркивает его роль как ответственного и надежного участника в экосистеме AI.

Как GPTBot сканирует веб?

GPTBot — это сложная система, которая использует уникальные методы и инструменты для сканирования веб-сайтов. Вот как это работает:

Использование пользовательского агента

Система использует определенный пользовательский агент для сканирования веб-сайтов. Это означает, что GPTBot имеет уникальный идентификатор, который позволяет веб-сайтам распознать его при сканировании. Владельцы сайтов могут узнать GPTBot по следующему токену:

User agent token: GPTBot

Full user-agent string: Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; GPTBot/1.0; +https://openai.com/gptbot)

- Соблюдение правил robots.txt GPTBot уважает правила, установленные в файле robots.txt веб-сайта. Если сайт не хочет, чтобы его сканировали, он может установить соответствующие правила в этом файле, и GPTBot будет их соблюдать.

- Фильтрация и выбор источников GPTBot не просто сканирует все подряд. Он тщательно выбирает источники, основываясь на критериях качества и релевантности. Это обеспечивает, что собираемые данные являются ценными и полезными для улучшения моделей ИИ.

- Технологические аспекты Сканирование веба GPTBot не ограничивается простым чтением страниц. Он использует сложные алгоритмы и методы для анализа структуры сайта, контента и других элементов, чтобы определить, какие данные могут быть полезны.

Процесс сканирования веба GPTBot — это сложный и хорошо продуманный процесс, который сочетает технологическую изощренность с этическими и практическими соображениями. Это делает GPTBot не просто инструментом, а важным участником в области искусственного интеллекта, способным собирать данные, которые действительно имеют значение.

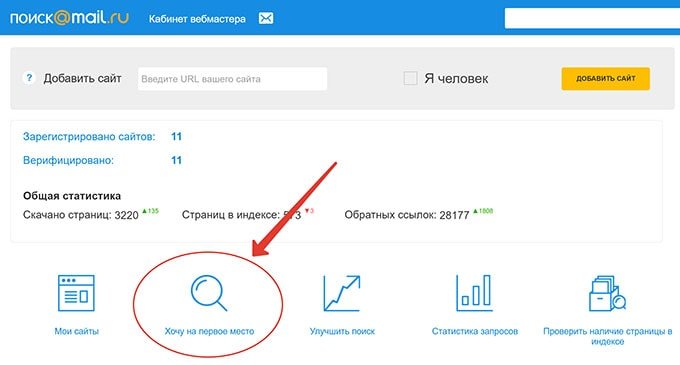

Управление доступом к GPTBot

OpenAI дает веб-администраторам возможность выбирать, разрешать ли GPTBot доступ к их сайтам.

Ограничение доступа

Если владельцы сайтов хотят ограничить доступ GPTBot ко всему сайту, они могут изменить файл robots.txt, добавив следующие строки:

User-agent: GPTBot

Disallow: /

В отличие от этого, те, кто хочет предоставить частичный доступ, могут настроить каталоги, к которым GPTBot может получить доступ. Для этого добавьте в файл robots.txt следующее:

User-agent: GPTBot

Allow: /directory-1/

Disallow: /directory-2/ Юридические и этические вопросы

Запуск GPTBot вызвал дебаты о юридической и этической стороне использования веб-данных для обучения собственных систем ИИ.Вопросы авторских прав

Основной проблемой является использование защищенного авторским правом контента без атрибуции. Некоторые считают, что это может привести к нарушению авторских прав.

Заключение

GPTBot открывает сложные вопросы владения, справедливого использования и стимулов создателей веб-контента. Это шаг вперед в развитии ИИ, но также поднимает вопросы о прозрачности и этике.

Ссылки и источники

- Оригинальная статья на Search Engine Journal