Всем привет! Это руководство предназначено для того, чтобы помочь новичкам начать работу с Screaming Frog SEO Spider. В нем рассказывается о начальной настройке, о том, как начать сканирование, а также о просмотре отчетов и обнаруженных проблемах.

О Screaming Frog SEO Spider

Screaming Frog SEO Spider — это инструмент для сканирования веб-сайтов, разработанный для того, чтобы помочь SEO-специалистам и компаниям извлекать данные на сайте, проводить аудит SEO-проблем и анализировать результаты в режиме реального времени. Функции включают обнаружение дубликатов страниц, визуализацию сайта, планирование сканирования, аутентификацию на основе форм, создание XML-карты сайта и создание разного рода отчетов.

Инструмент позволяет специалистам по поисковой оптимизации сканировать небольшие или большие веб-сайты, отслеживать неработающие ссылки и ошибки сервера и экспортировать исходные URL-адреса разработчикам для исправления. Цифровые маркетологи могут анализировать заголовок страницы и метаописания, обнаруживать временные и постоянные перенаправления и обнаруживать заблокированные URL-адреса с помощью директив тегов. Это также позволяет пользователям очищать данные из HTML веб-страниц, используя путь CSS, XPath или регулярные выражения (regex).

Screaming Frog SEO Spider интегрируется с различными сторонними платформами, такими как Google Analytics, Google Seach Console, PageSpeed и Link Metrics. Он доступен бесплатно и по годовой подписке и обеспечивает поддержку по телефону, электронной почте и в документации.

Этот инструмент позволяет ввести URL-адрес любого сайта и нажать кнопку "Пуск", чтобы получить полезные результаты. В течение минуты или меньше Screaming Frog выдает список всех страниц сайта с информацией, которую вы можете проанализировать, чтобы убедиться, что они оптимизированы для SEO, например, заголовки страниц, теги заголовков и коды состояния. Вы также можете использовать его для изучения сайтов конкурентов, чтобы понять, как вы можете превзойти их.

Screaming Frog работает как сканеры Google: он позволяет сканировать любой веб-сайт, включая сайты электронной коммерции. Но этот инструмент «SEO-паука» поднимает сканирование на ступеньку выше, предоставляя вам релевантные данные на сайте и создавая удобоваримую статистику и отчеты. С более простыми данными сайта от Screaming Frog вы можете легко увидеть, над какими областями вашего сайта нужно поработать.

Программное обеспечение Screaming Frog может помочь вам выполнить следующие задачи в области SEO:

- Поиск битых ссылок;

- Поиск временных и постоянных редиректов;

- Анализ метаданных;

- Поиск дублированного контента;

- Проверка robots.txt и других директив;

- Создание карты сайта XML;

- Анализ архитектуры сайта.

И, конечно же, вы можете сделать намного больше с Screaming Frog. Мы рассмотрим эти дополнительные функции в другом разделе.

Руководство по началу работы с SEO Spider

Установка

Для начала вам необходимо скачать и установить SEO Spider , который может сканировать до 500 URL-адресов за раз. Он доступен для Windows, MacOS и Ubuntu.

Затем дважды щелкните загруженный установочный файл SEO Spider и следуйте инструкциям программы установки.

Вы можете купить лицензию, которая снимает ограничение сканирования в 500 URL-адресов, открывает конфигурацию и предоставляет доступ к более продвинутым функциям. Посмотрите страницу с ценами, чтобы сравнить бесплатные и платные функции.

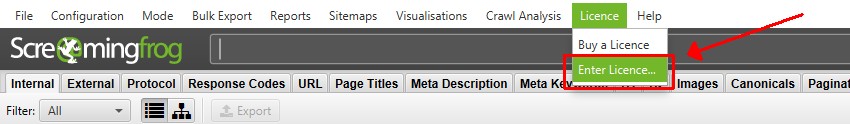

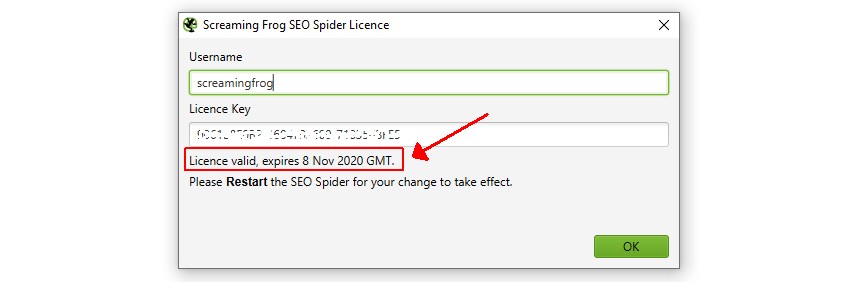

Активация лицензии

Если вы хотите использовать бесплатную версию, вы можете пропустить этот шаг. Однако если вы хотите просканировать более 500 URL-адресов, сохранить и повторно открыть сканирование и получить доступ к расширенным функциям, вы можете приобрести лицензию.

При покупке лицензии вам предоставляется имя пользователя и лицензионный ключ, которые необходимо ввести в приложении в разделе «Лицензия > Ввести лицензионный ключ».

При правильном вводе лицензия скажет, что она действительна, и покажет дату истечения срока действия. Затем вам потребуется перезапустить приложение, чтобы снять ограничение сканирования и разрешить доступ к конфигурации и платным функциям.

Если в лицензии указано, что она недействительна, ознакомьтесь с часто задаваемыми вопросами о распространенных проблемах с недействительной лицензией, чтобы устранить неполадки.

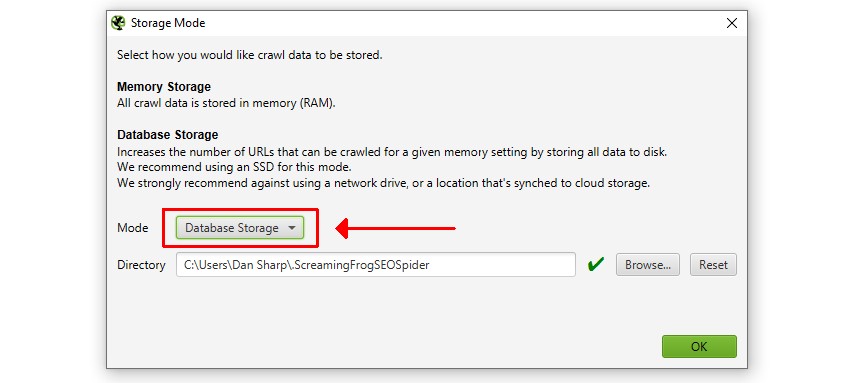

Настройка памяти и хранилища

Вы можете пропустить этот шаг, если используете бесплатную версию или просто хотите сразу приступить к сканированию. Однако, если вы используете платную версию, я рекомендую настроить ее с самого начала.

Если у вас есть SSD, то разработчики рекомендуют переключиться в режим хранения базы данных. Перейдите в «Конфигурация > Система > Режим хранения» и выберите «Режим хранения базы данных».

Режим хранения базы данных дает огромные преимущества, в том числе позволяет SEO Spider сканировать больше URL-адресов, автоматически сохранять данные сканирования и позволяет вам быстрее получать доступ к старым сканам.

Если у вас нет SSD, придерживайтесь режима хранения в оперативной памяти. Вы по-прежнему можете сохранять сканирование и сканировать множество URL-адресов, если у вас достаточно оперативной памяти.

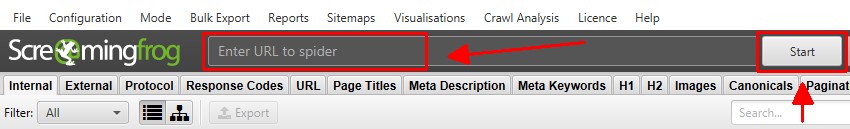

Запуск сканирования

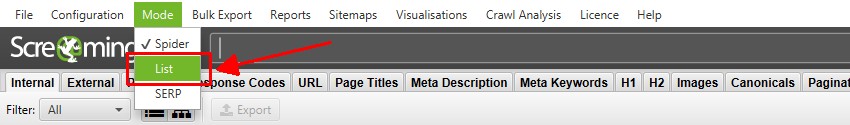

Существует два основных режима сканирования. Режим «Spider» по умолчанию, который сканирует веб-сайт, или «List», который позволяет загружать список URL-адресов для сканирования.

Вы можете начать обычное сканирование «Spider», вставив адрес домашней страницы в поле «Enter URL to spider» и нажав «Start».

Это просканирует и проверит введенный URL-адрес и все URL-адреса, которые он может обнаружить по гиперссылкам в HTML-страницах на том же поддомене.

Сканирование будет обновляться в режиме реального времени, а скорость и общее количество завершенных и оставшихся URL-адресов можно просмотреть в нижней части приложения.

Вы можете нажать «пауза» и «возобновить» сканирование в любое время. Вы также можете сохранить сканирование и возобновить его позже. Подробнее о сохранении чуть позже.

Если вы предпочитаете сканировать список URL-адресов, а не весь сайт, нажмите «Mode > List», чтобы загрузить или вставить список URL-адресов.

Настройка сканирования

Вам не нужно настраивать конфигурацию для сканирования веб-сайта, поскольку SEO Spider по умолчанию настроен на сканирование аналогично Google.

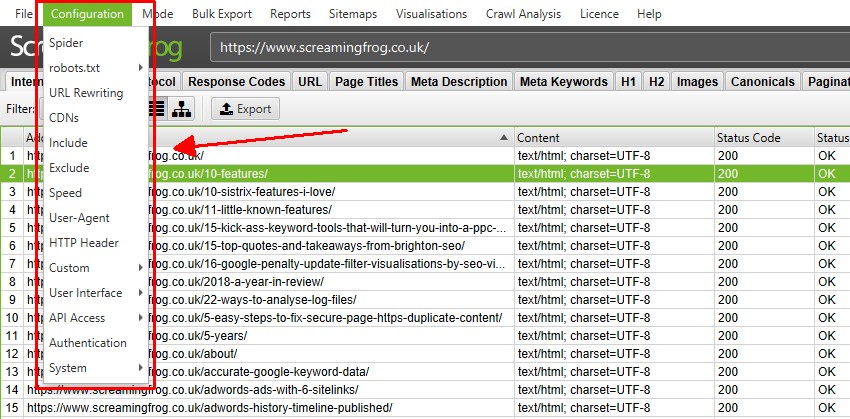

Однако существует множество способов настроить сканирование для получения нужных данных. Проверьте параметры в разделе «Configuration» в инструменте и обратитесь к нашему руководству пользователя для получения подробной информации о каждой настройке.

Некоторые из наиболее распространенных способов контроля того, что сканируется — это сканирование определенной подпапки, использование функций исключения (чтобы избежать сканирования URL-адресов по шаблону URL) или включения функций.

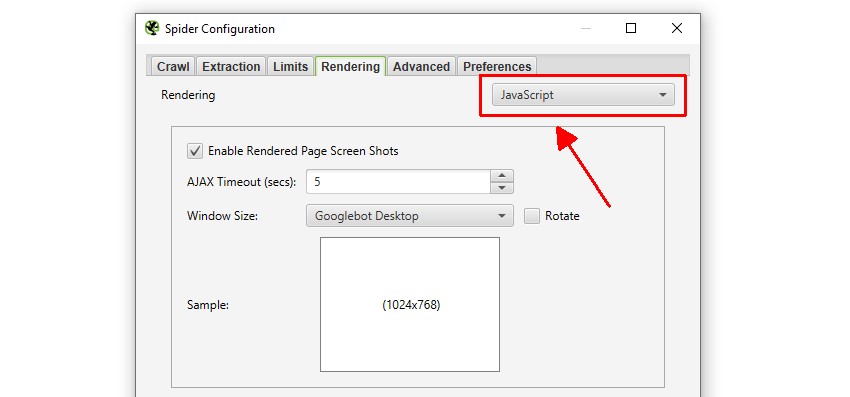

Если ваш веб-сайт использует JavaScript для заполнения контента, вы также можете переключиться в режим рендеринга JavaScript в разделе «Configuration > Spider > Rendering».

Это будет означать, что JavaScript выполняется, и SEO Spider будет сканировать контент и ссылки в отображаемом HTML.

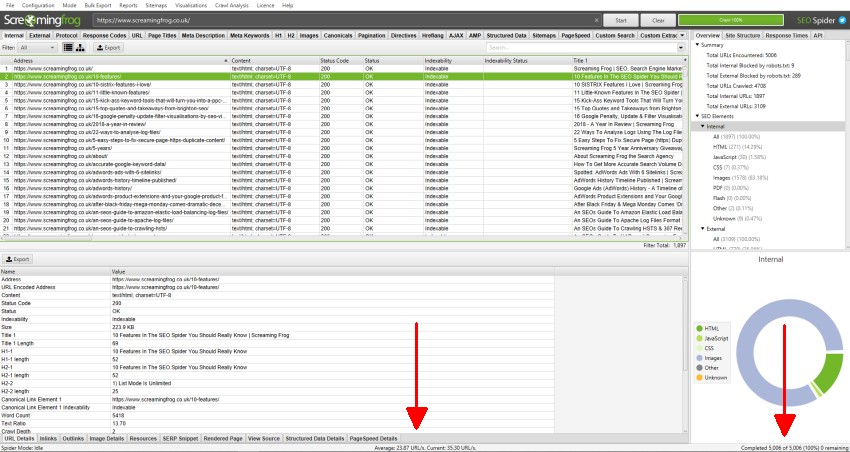

Просмотр данных сканирования

Данные сканирования заполняются в режиме реального времени в SEO Spider и отображаются на вкладках. Вкладка «Internal» содержит все данные, обнаруженные при сканировании просматриваемого веб-сайта. Вы можете прокручивать вверх, вниз и вправо, чтобы увидеть все данные в различных столбцах.

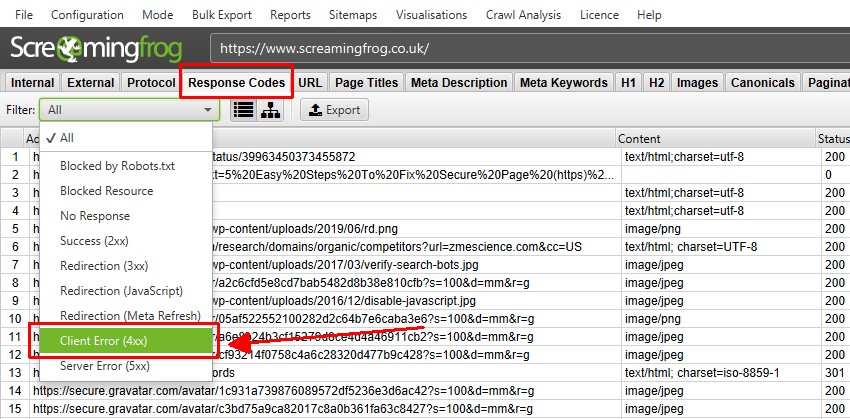

Вкладки сосредоточены на разных элементах, и на каждой из них есть фильтры, которые помогают уточнять данные по типу и потенциальным обнаруженным проблемам. Вкладка «Response Codes» и фильтр «Client Error (4xx)» покажут вам, например, все обнаруженные страницы 404.

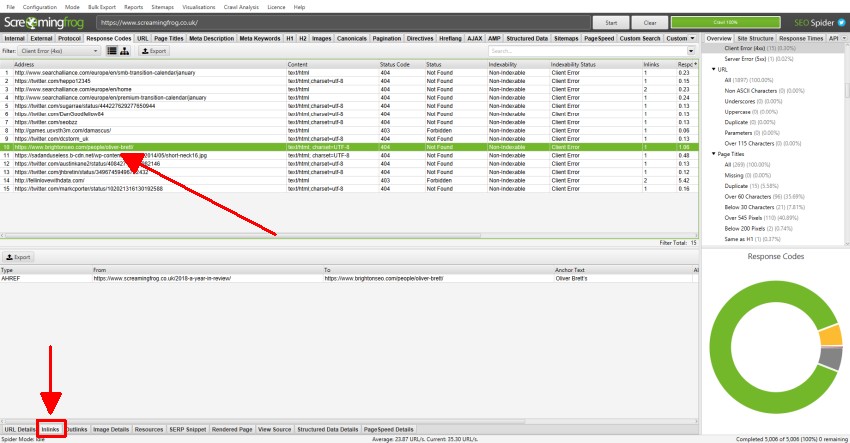

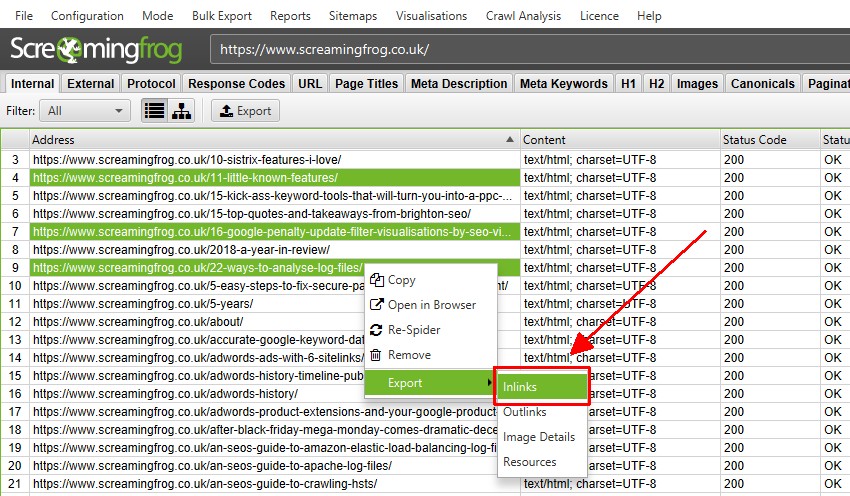

Вы можете нажать на URL-адреса в верхнем окне, а затем на вкладки внизу, чтобы заполнить нижнюю панель окна.

Эти вкладки предоставляют более подробную информацию об URL-адресе, например, их входящие ссылки (страницы, которые ссылаются на них), исходящие ссылки (страницы, на которые они ссылаются), изображения, ресурсы и многое другое.

В приведенном выше примере мы видим ссылки на неработающую ссылку, обнаруженную во время сканирования.

Обнаружение ошибок и проблем

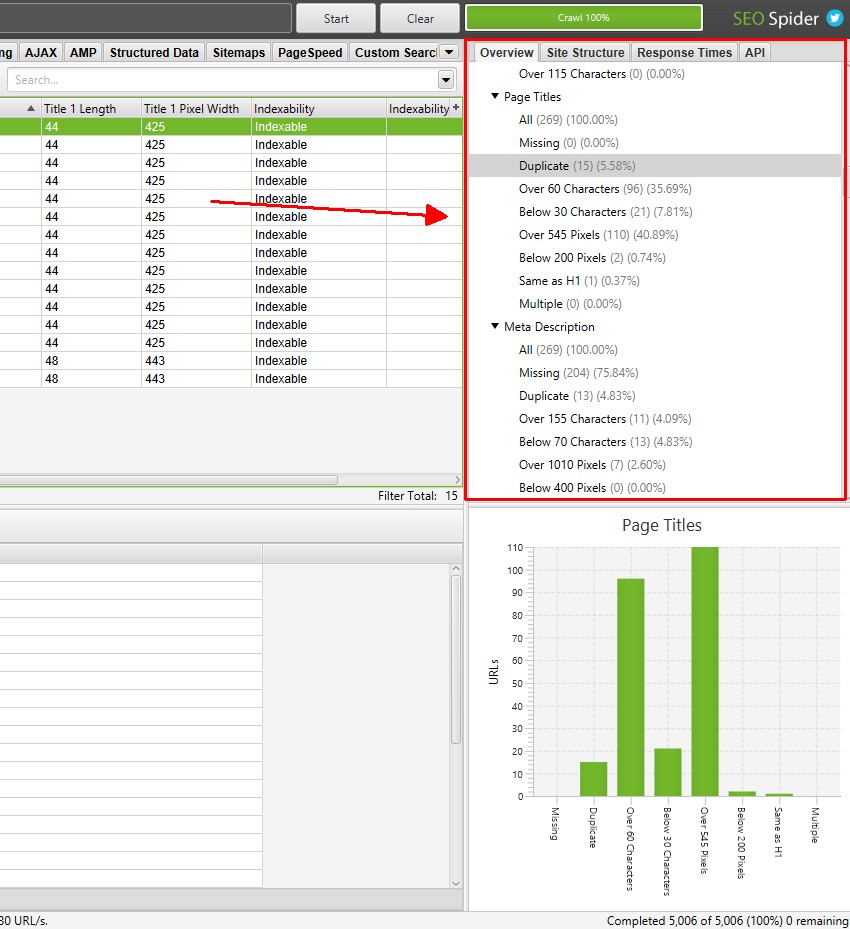

На вкладке «Overview» в правом окне отображается сводка данных сканирования, содержащихся на каждой вкладке и фильтре. Вы можете прокручивать каждый из этих разделов, чтобы определить потенциальные ошибки и обнаруженные проблемы, без необходимости нажимать на каждую вкладку и фильтровать.

Количество затронутых URL-адресов обновляется в режиме реального времени во время сканирования для большинства фильтров, и вы можете щелкнуть по ним, чтобы перейти непосредственно на соответствующую вкладку и фильтр.

SEO Spider не говорит вам, как делать SEO, он предоставляет вам данные для принятия более обоснованных решений. Тем не менее, «фильтры» дают подсказки по конкретным проблемам, которые следует решить или, по крайней мере, дополнительно рассмотреть в контексте вашего сайта.

Изучите эти подсказки, и если вы не уверены в значении вкладки или фильтра, просто обратитесь к нашему руководству пользователя. На каждой вкладке есть раздел (например, заголовки страниц , канонические значения и директивы ), в которых поясняется каждый столбец и фильтр.

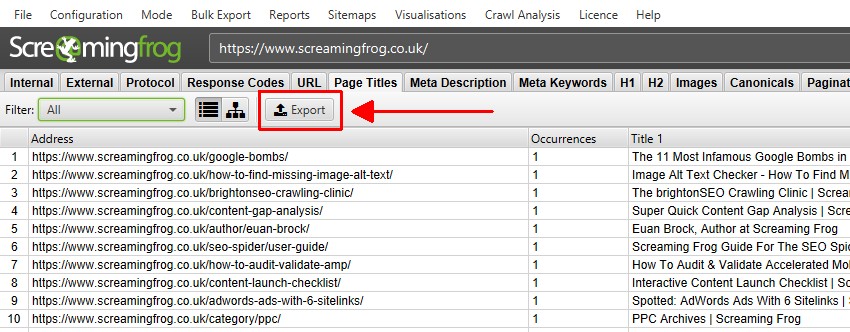

Экспорт данных

Вы можете экспортировать все данные в электронные таблицы из сканирования. Просто нажмите кнопку «Экспорт» в верхнем левом углу, чтобы экспортировать данные из вкладок и фильтров верхнего окна.

Чтобы экспортировать данные нижнего окна, щелкните правой кнопкой мыши по URL-адресам, с которых вы хотите экспортировать данные в верхнем окне, затем выберите один из вариантов.

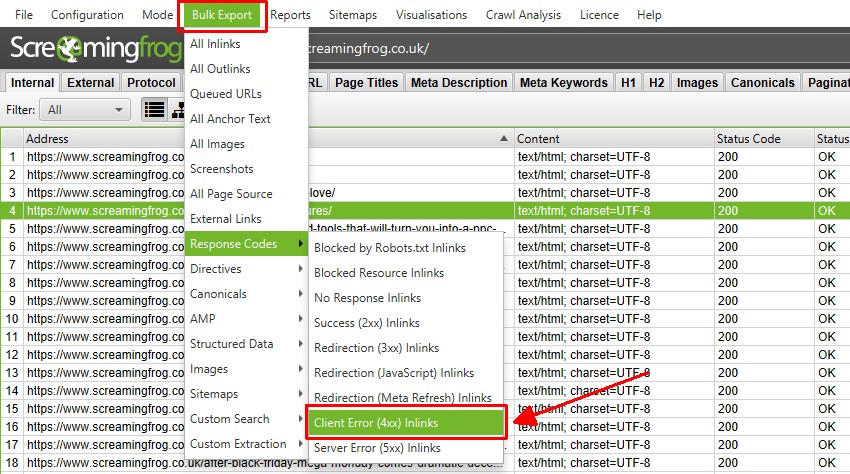

Также есть опция «Bulk Export», расположенная в меню верхнего уровня. Это позволяет вам экспортировать исходные ссылки, например, «входящие ссылки» на URL-адреса с определенными кодами состояния, такими как ответы 2XX, 3XX, 4XX или 5XX.

В приведенном выше примере выбор параметра «Client Error 4XX In Links» выше приведет к экспорту всех внутренних ссылок на все страницы с ошибками (страницы, которые ссылаются на страницы с ошибкой 404).

Сохранение и открытие обходов

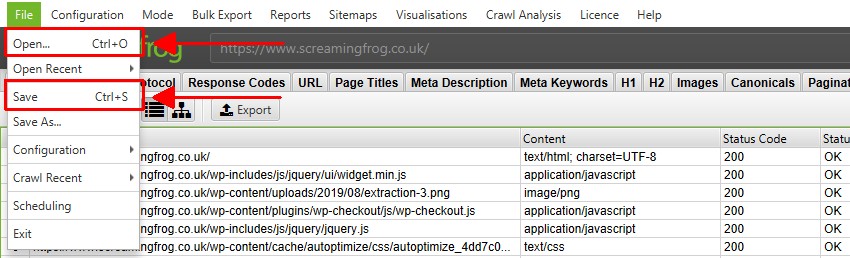

Вы можете сохранять и открывать обходы только с лицензией. В режиме хранения в памяти, по умолчанию вы можете сохранить сканирование в любое время (когда оно было приостановлено или завершено) и повторно открыть, выбрав «File > Save» или «File > Open».

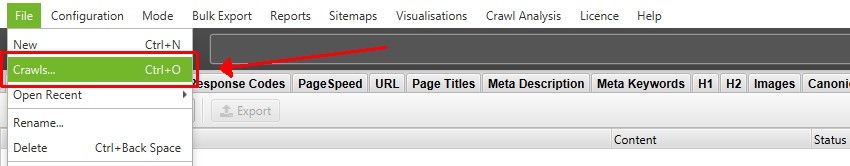

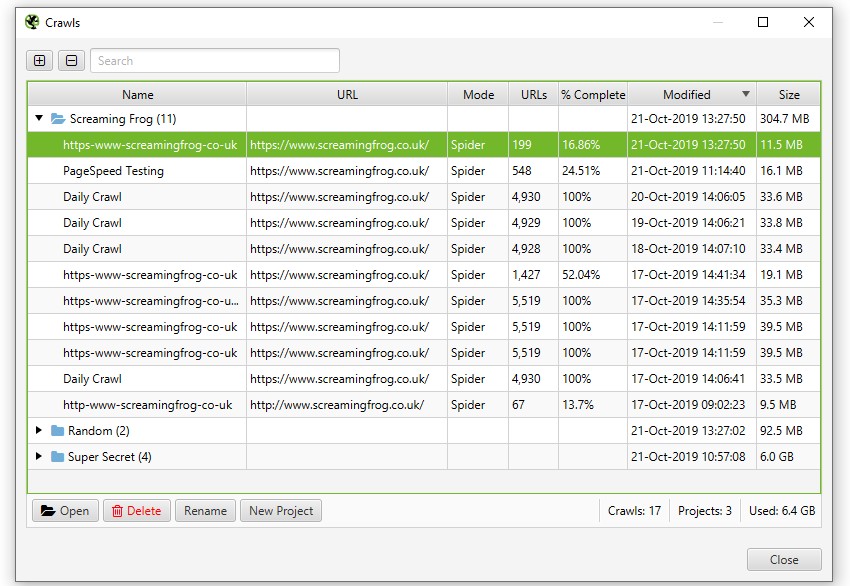

В режиме хранения базы данных, обходы автоматически «сохраняются» и фиксируются в базе данных во время обхода. Чтобы открыть сканирование, нажмите «File > Crawls» в главном меню.

В окне «Crawls» отображается обзор автоматически сохраненных обходов, где вы можете открывать, переименовывать, организовывать в папки проекта, дублировать, экспортировать или удалять их массово.

Популярные и расширенные функции

Как вы сами понимаете, в рамках одной статьи не возможно охватить все варианты использования и функции этого инструмента, поэтому рекомендую вам изучить доступные варианты и при необходимости обратиться к подробному руководству пользователя.

Тем не менее, прилагаю список некоторых наиболее распространенных применений SEO Spider со ссылками для дополнительного изучения.

- Найдите неработающие ссылки — мгновенно просканируйте веб-сайт и найдите неработающие ссылки (404) и ошибки сервера. Массовый экспорт ошибок и исходных URL для исправления или отправки разработчику.

- Аудит перенаправлений. Найдите временные и постоянные перенаправления, определите цепочки и петли перенаправлений или загрузите список URL-адресов для аудита при переносе сайта.

- Анализ заголовков и метаописаний страниц. Просмотрите заголовки и метаописания каждой страницы, чтобы обнаружить неоптимизированные, отсутствующие, повторяющиеся, длинные или короткие элементы.

- Просмотрите директивы и канонические правила . Просмотрите URL-адреса, заблокированные файлом robots.txt, директивами meta robots или X-Robots-Tag, такими как noindex или nofollow, и проверьте канонические правила.

- Найдите alt текст и атрибуты отсутствующего изображения. Найдите изображения, в которых отсутствует alt текст, и просмотрите alt текст каждого изображения при сканировании.

- Проверка на дублированный контент — проанализируйте веб-сайт на наличие точных дубликатов страниц и почти дублирующегося «похожего» контента.

- Сканирование веб-сайтов JavaScript . Отрисовывайте веб-страницы с помощью встроенного Chromium WRS для сканирования динамических веб-сайтов и фреймворков с большим количеством JavaScript, таких как Angular, React и Vue.js.

- Визуализируйте архитектуру сайта . Оцените структуру внутренних ссылок и URL-адресов с помощью интерактивных схем сканирования и каталогов, а также визуализаций сайта в виде древовидного графа.

- Создание файлов Sitemap в формате XML . Быстро создавайте файлы Sitemap в формате XML и файлы Sitemap в формате XML с расширенной настройкой URL-адресов, включая последние изменения, приоритет и частоту изменений.

- Аудит международной настройки (hreflang) — Найдите распространенные ошибки и проблемы с аннотациями hreflang в HTML, через HTTP-заголовок или в XML-картах сайта в масштабе.

- Анализируйте PageSpeed и Core Web Vitals — подключайтесь к PSI API для Core Web Vitals (полевые данные CrUX), метрикам Lighthouse, возможностям повышения скорости и диагностике в любом масштабе.

Также предлагаю список некоторых из наиболее популярных функций:

- Schedule Crawls — запланируйте сканирование для автоматического запуска в SEO Spider, как разовое или через выбранные промежутки времени.

- Сравните сканирование и промежуточное сканирование — отслеживайте ход решения проблем и возможностей SEO и смотрите, что изменилось между сканированиями. Сравните промежуточную среду с рабочей средой, используя расширенное сопоставление URL-адресов.

- Интеграция с GA, GSC и PSI . Подключайтесь к API Google Analytics , Search Console и PageSpeed Insights и извлекайте данные о пользователях и производительности для всех URL-адресов при сканировании для более глубокого понимания.

- Пользовательский поиск HTML — находите все, что хотите, в исходном коде веб-сайта. Будь то код Google Analytics, конкретный текст или код и т. д.

- Извлечение данных с помощью XPath . Собирайте любые данные из HTML-кода веб-страницы, используя путь CSS, XPath или регулярное выражение. Это могут быть социальные метатеги, дополнительные заголовки, цены, SKU и многое другое.

- Сканирование промежуточных сайтов и сайтов разработки . Войдите на промежуточный веб-сайт, используя базовую аутентификацию, дайджест или веб-формы.

- Управляйте через командную строку — программно запускайте сканирование через командную строку для интеграции с вашими собственными внутренними системами.

Приведенное выше руководство должно помочь проиллюстрировать простые шаги, необходимые для начала работы с SEO Spider.